3Dモデルから画像生成?Stable Diffusionで実現する新しい表現方法3DモデルとAIの融合とは!!?

Stable Diffusionで3Dモデルを画像生成に活用!ポーズや輪郭を指定して、今までにない創造性を発揮しよう!「3DModel&PoseLoader」拡張機能とControlNetで、あなただけのオリジナル画像を生成!

💡 Stable Diffusionで、3Dモデルから画像生成が可能になりました。

💡 3Dモデルのポーズやアングルを自由に調整して、画像生成できます。

💡 ControlNetなどの拡張機能を活用することで、より精度の高い画像生成が実現できます。

それでは、最初の章として、3Dモデルから画像生成についてお話しましょう。

3Dモデルから画像生成 - 新しい可能性

3Dモデルから画像生成? どうやって?

ポーズ抽出や輪郭生成で

3D モデルから画像生成は、新たな表現方法として注目されていますね。

公開日:2023/10/06

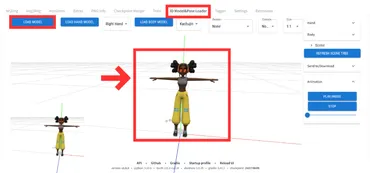

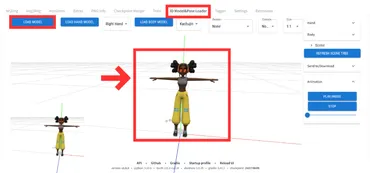

✅ 3D Model & Pose Loaderは、Stable Diffusionの拡張機能で、3Dモデルを読み込んでControlNetで元の画像として利用できる機能です。これにより、呪文(プロンプト)を打ち込む必要がなく、簡単に3Dモデルに基づいた画像を生成できます。

✅ インストールには、事前にControlNetをインストールする必要があります。ControlNetと3D Model & Pose Loaderをインストールした後、Stable Diffusion Web UIを再起動します。

✅ 3D Model & Pose Loaderの使い方としては、まず生成したい3Dモデルをダウンロードし、Stable Diffusion Web UIに読み込みます。その後、モデルのポーズを調整し、ControlNetに転送することで画像生成が行われます。

さらに読む ⇒romptn AI | 日本最大級のAI情報ポータルサイト出典/画像元: https://romptn.com/article/158653Dモデルを用いた画像生成は、従来の手描きでは難しかった表現も可能にする、画期的な技術ですね。

Stable Diffusion WebUIの拡張機能「3DModel&PoseLoader」を使えば、3Dモデルからポーズを抽出して画像生成したり、3Dモデルの輪郭や線のみを元に画像生成したりできます。

この機能は、より柔軟で創造的な画像生成を実現するために開発されました。

マジですか!?3Dモデルから画像生成できるなんて、夢のようです!

拡張機能の導入と3Dモデルの準備

Stable Diffusionで3Dモデルを使うには?

拡張機能で読み込み

3Dモデルから画像を生成する新しい世界ですね。

公開日:2023/03/18

✅ 「3D Model&Pose Loader」は、Stable Diffusion web UIのControlNet拡張機能に3Dモデルを読み込ませて、ControlNetの元画像として使えるようにする拡張機能です。

✅ obj、stl、fbx、vrmなど、様々な3Dモデル形式に対応しており、3Dアニメーションの任意のフレームをキャプチャしてControlNetに転送することもできます。

✅ Stable Diffusion web UIとControlNetをインストールした上で、拡張機能一覧から「3D Model&Pose Loader」をインストールすれば、簡単に利用できます。

さらに読む ⇒くろくまそふと出典/画像元: https://kurokumasoft.com/2023/03/18/web-ui-3d-model-loader/様々な3Dモデル形式に対応しているのは、素晴らしいですね!。

まず、Stable Diffusion WebUIに「3DModel&PoseLoader」を導入します。

その後、Maximoなどのサイトから3Dモデルをダウンロードして、拡張機能にアップロードします。

へぇー、3Dモデルを直接使えるんですね!便利そう。

3Dモデルからポーズと構図を抽出

3Dモデルからポーズ画像を作るには?

アニメーションでポーズ固定、調整、保存

3Dモデルのポーズや構図を抽出することで、より自然な画像生成が可能になりますね。

✅ この記事は、クリスタを使って3Dポーズをイラスト向きに変換する方法を紹介しています。

✅ 具体的には、3Dモデルを線画に変換した後、顔や指先などの部分を修正する手順を解説しています。

✅ 記事には、3Dモデルの変換から線画の修正まで、具体的な操作手順が画像と共に示されています。

さらに読む ⇒Make better art | Clip Studio TIPS | Sharing creative knowledge出典/画像元: https://tips.clip-studio.com/ja-jp/articles/24433Dモデルからポーズを抽出する機能は、イラスト制作に役立ちそうですね。

3Dモデルをアップロードしたら、アニメーションを再生して生成したいポーズに止め、アングルや構図を調整します。

そして、画像を保存します。

3Dモデルからポーズを抽出できるなんて、すごいですね!

ControlNetで画像生成を強化

ControlNetは何に役立ちますか?

3Dモデル情報を活用

ControlNetは、画像生成をより高度にコントロールできる技術ですね。

✅ ControlNetとは、Stable Diffusion の Extension で、画像生成をユーザーがコントロールできるようになる技術です。入力画像から線画やポーズを推定して別画像を生成し、例えば、元の画像の輪郭を維持したまま塗り替えたり、ポーズだけを抽出して別の画像に適用したりすることができます。

✅ ControlNet のインストールは、Stable Diffusion の Web-UI の Extension を使用します。GitHub リポジトリの URL を貼り付けることでインストールできます。なお、Google Colab にインストールする場合、 Web-UI からインストールするとエラーになる場合があり、extensions フォルダで git clone する必要があります。

✅ ControlNet を使用するためには、輪郭、ポーズ、奥行きなどの推定を行うために、別途 pth ファイルをダウンロードする必要があります。これらの pth ファイルは、ControlNet の GitHub リポジトリから入手できます。使用するアルゴリズムに対応した pth ファイルだけをダウンロードすればよく、DL する前に記事を熟読することを推奨します。pth ファイルは、Stable Diffusion Web-UI の extensions フォルダにある model フォルダに保存します。

さらに読む ⇒Top出典/画像元: https://www.ultra-noob.com/blog/2023/14/ControlNetを活用することで、より精度の高い画像生成が可能になりますね。

次に、ControlNetを有効化します。

ControlNetを使用することで、3Dモデルの輪郭や線などの情報を基に、より精度の高い画像生成が可能です。

ControlNetって、なんか面白そうだな!

ControlNetを活用した画像生成

ControlNetでDepthを使うと何ができますか?

画像の奥行き情報を制御できます

ControlNet Depthは、奥行きや構図を考慮した画像生成に役立ちますね。

✅ ControlNet Depthは、Stable Diffusionの拡張機能の一つであり、元画像から奥行きや構図を抽出して別の画像を生成することができます。

✅ ControlNet Depthのインストールは、Stable Diffusion Web UIの拡張機能であるContorlNetをインストールし、ControlNet Depthのモデルを設定することで行います。

✅ ControlNet Depthの使い方としては、Stable Diffusion Web UIのtxt2imgタブを開き、元画像をアップロードし、ControlNetメニューからDepthを選択して、Preprocessorをdepth_midas、Modelをcontrol_v11f1p_sd15_depth_fp16に設定し、💥アイコンをクリックして特徴抽出を行い、生成パラメータを設定してGenerateボタンをクリックします。

さらに読む ⇒【業界最安級】GPUクラウドサービス| GPUSOROBAN出典/画像元: https://soroban.highreso.jp/article/article-077ControlNet Depthは、元画像の情報を活用して、自然な画像を生成するのに役立ちますね。

この記事では、ControlNetの種類としてDepthを使用する例が紹介されています。

ControlNetの導入方法については、別の記事で解説されています。

ControlNet Depthって、どんな機能ですか?

このように、Stable Diffusionは、3Dモデルを活用した画像生成など、新たな可能性を秘めています。

💡 Stable Diffusion は、3D モデルを活用した画像生成を可能にする画期的な技術です。

💡 ControlNet などの拡張機能を使用することで、画像生成をより高度にコントロールできます。

💡 3D モデルと AI の融合は、新たな表現方法を生み出す可能性を秘めています。